近日,中国计算机学会(CCF)推荐的A类国际学术会议ACM Multimedia 2023在加拿大渥太华落下帷幕,上海交通大学BCMI实验室吕宝粮团队发表了题为“Multimodal Adaptive Emotion Transformer with Flexible Modality Inputs on A Novel Dataset with Continuous Labels”的论文。国际多媒体学术会议(ACM International Conference on Multimedia,简称ACM MM)由国际计算机协会(ACM)发起,是多媒体处理、分析与计算领域具有影响力的国际会议。

从生理信号中识别情绪是一个广受关注的话题,研究人员不断开发出新的情绪感知技术。然而,深度学习的出现凸显了准确解码人类情绪对高质量情绪数据集的需求。吕宝粮团队开发了具有连续标签的七类多模态情绪数据集并提出了基于连续标签数据集的灵活模态输入的多模态自适应情绪Transformer。

论文简介

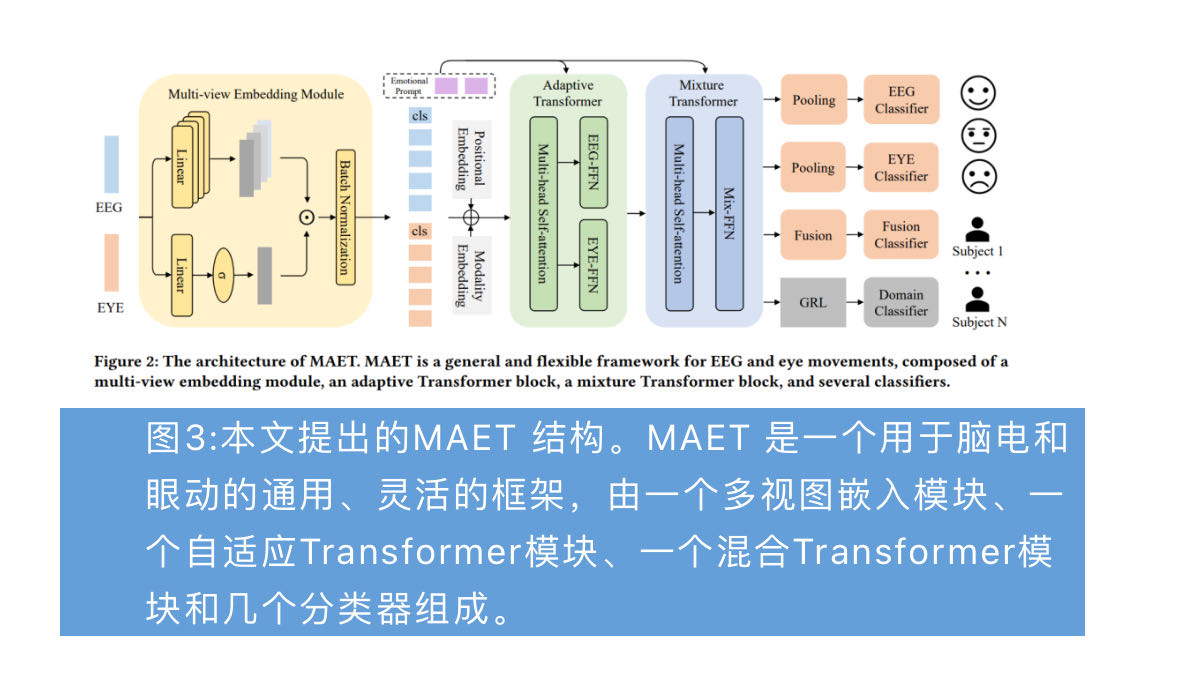

本研究提出了一种新型多模态情绪数据集,该数据集结合了脑电图(EEG)和眼动信号,探索了人的七种基本情绪(快乐、悲伤、恐惧、厌恶、惊讶、愤怒和中性)。这七种情绪由 80 段不同的视频诱发,并通过连续标签表示相应情绪的强度,从而可对情绪解码进行更全面和细致的研究。在此基础上,我们还提出了一种新型多模态自适应情绪Transformer(MAET),它可以灵活处理单模态和多模态输入。MAET 中使用了对抗训练来减少主体差异,从而增强了领域泛化能力。我们进行了广泛的实验,包括被试依赖和跨被试条件,证明了 MAET 在处理各种输入方面的优异性能。实验结果表明,使用连续标签对高情感唤起数据进行过滤是有效的。此外,我们还观察到了脑电和眼动之间的互补特性。

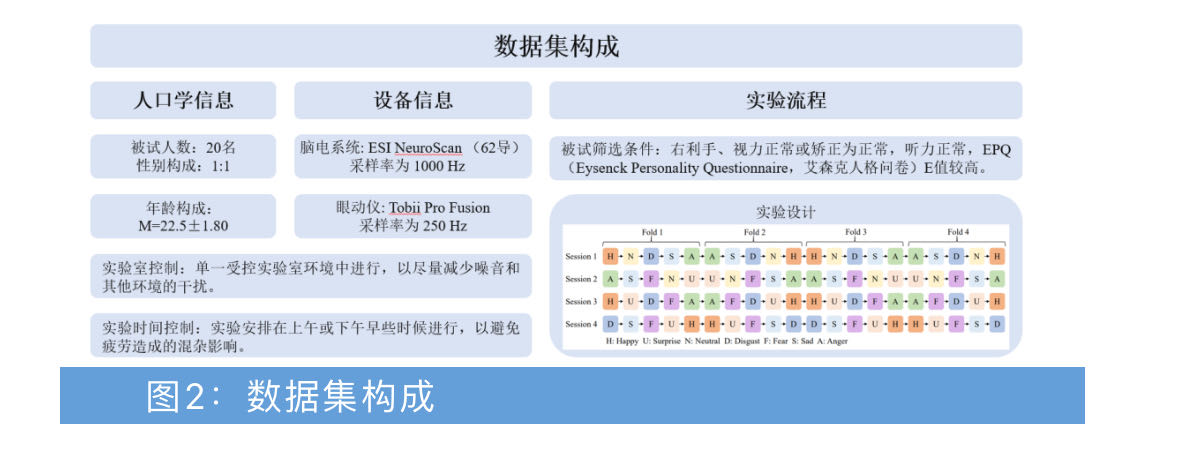

本研究数据集由20名被试组成(图2),每名被试需完成80个视频素材的观看,分四次实验进行,每次仅诱发被试的五种情绪,以减少让被试转换过多的情绪状态所产生的对情绪诱发效果的影响。每次实验包含20个试次,单试次包括素材观看和主观评分(1-10分)。视频片段的播放顺序经过了特别的设计,以避免被试情绪频繁切换,因为人的情绪往往是逐渐转变的。在每次实验结束时,要求被试回顾所有20个视频片段,回忆他们经历过的情绪反应,实时标记情绪变化状态。连续标签的范围在 0%到100%之间,数值越大,表示所诱发的情绪越强烈。

MAET 结构训练过程分为两个步骤(图3)。首先使用脑电和眼动特征对MAET 进行训练,使其具备处理多模态输入的能力。之后,MAET 的主干被冻结,我们引入了情感提示微调,只对单一模态的情感提示和分类器进行调整。MAET 训练完成后,可以将脑电或眼动数据作为输入,也可以将脑电和眼动数据同时作为输入。给定输入特征,它会首先被传递给多视图嵌入模块,以将单个特征映射为来自不同视图的多个标记。然后,它被送入自适应Transformer和混合Transformer,最后由分类器预测情绪。

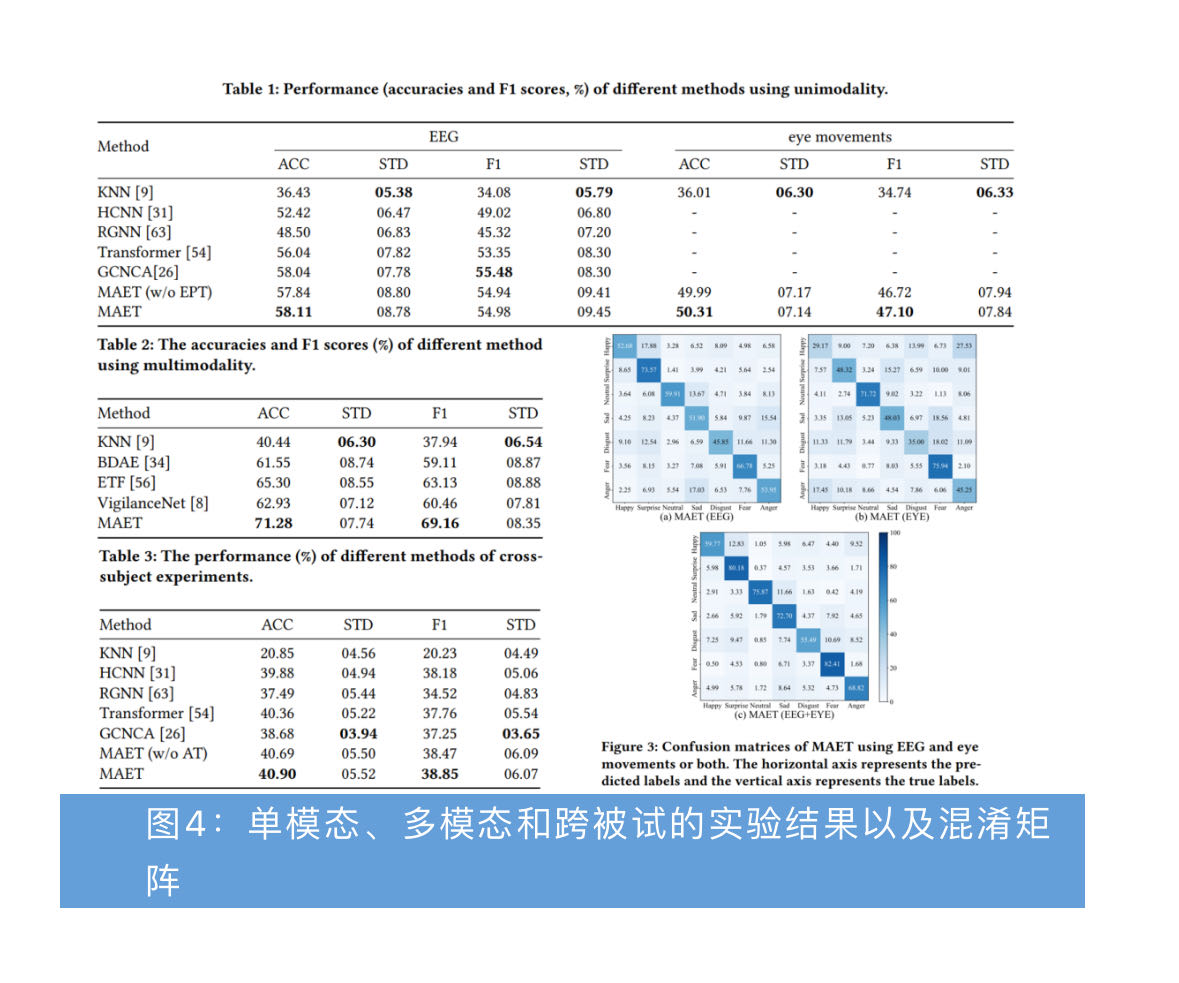

在对七种情绪进行分类时,MAET 的判别能力最强。具体来说,MAET在使用单独脑电信号时获得了最高的预测准确率58.11%(图4)。与其他情绪相比,MAET 对惊讶和恐惧情绪的区分准确率更高。此外,快乐情绪容易被误判为惊讶情绪,而中性情绪则更容易与悲伤情绪混淆。与其他情绪相比,悲伤和愤怒情绪在基于脑电信号的分类中更容易被误判为其他情绪,这表明悲伤和愤怒情绪的神经模式具有相似性。对于眼动信号,它在区分中性情绪和恐惧情绪方面表现出色。尽管如此,单独的眼动信号在快乐和厌恶情绪的分类中表现相对较差,其准确率低于 40%。从混淆矩阵可以看出,脑电信号在分辨快乐、惊讶、厌恶和愤怒情绪时取得了更好的结果,而眼动信号在分辨中性、悲伤和恐惧情绪时取得了更准确的结果。值得注意的是,快乐情绪和愤怒情绪之间有一些相似的眼动模式,原因是有27.53%的快乐情绪被误识别为愤怒情绪。另外,与单独使用脑电或眼动信号相比,使用多模态技术能更准确地对大多数情绪进行分类。

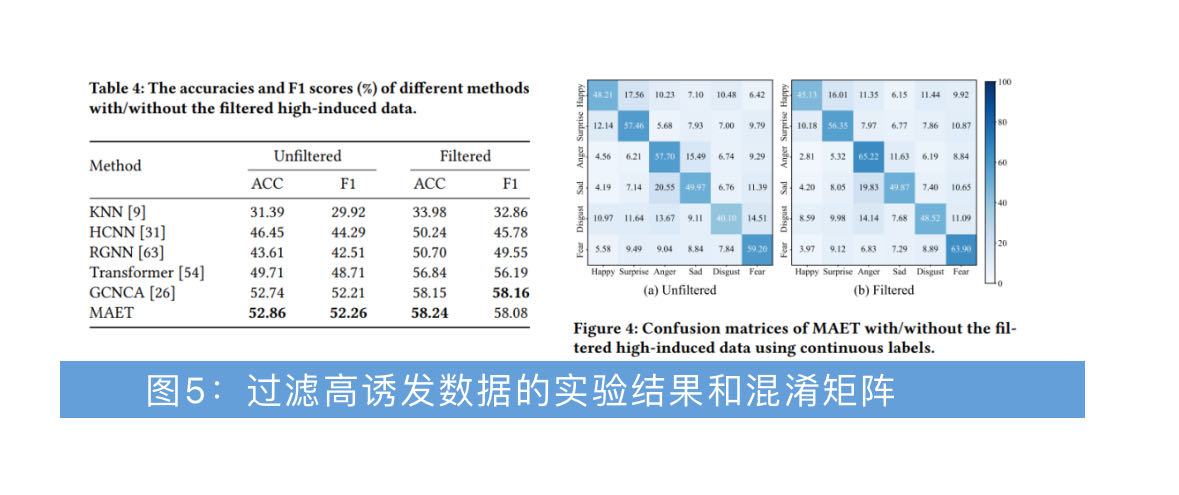

为了进一步研究分类性能与情绪强度之间的相关性,我们在未过滤和过滤的情况下对每种方法的分类性能进行了比较,并在过滤的情况下对低诱发数据进行了过滤。判断脑电信号是否为高诱发的标准是相应视频片段的得分大于50%的阈值。在所有方法中,只要使用过滤后的数据,分类准确率和 F1 分数就会大幅提高(图5)。通过过滤高诱发数据,愤怒、厌恶和恐惧情绪的准确率分别上升了7.52%、8.42%和4.7%,这凸显了过滤对区分这三种情绪的重要性。然而,快乐、惊讶和悲伤情绪的分类准确率略有下降。究其原因,可能是对于快乐、惊讶和悲伤情绪,受试被刺激材料唤起的时间较长,导致过滤后的数据不足。由于深度模型需要大量数据,过滤后数据不足可能是这三种情绪准确度下降的原因。这一实验结果表明,过滤后的高诱发数据对于易诱发情绪的分类具有重要意义。

• 开发了一个新的脑电和眼动情绪数据集,包括七种基本情绪(快乐、悲伤、恐惧、厌恶、惊讶、愤怒、中性)。

• 该数据集具有连续的标签,表明被试在观看视频时所经历的情感强度水平。

• 提出了一种新的方法MAET,它能够灵活地处理单模态和多模态输入。在单一模态和多模态情况下,对不同方法的性能进行了系统评估。

• 进行跨域实验,使用留一交叉验证来检查每种方法的性能。

• 对未过滤和过滤的情况进行了比较,以探索根据连续标签过滤数据的效果。实验结果表明,随着过滤数据的增加,精度有了相当大的提高。

上海交通大学计算机科学与工程系博士研究生姜卫邦为本文的第一作者,上海交通大学计算机科学与工程系吕宝粮教授为本文通讯作者。

文章地址:

https://dl.acm.org/doi/10.1145/3581783.3613797